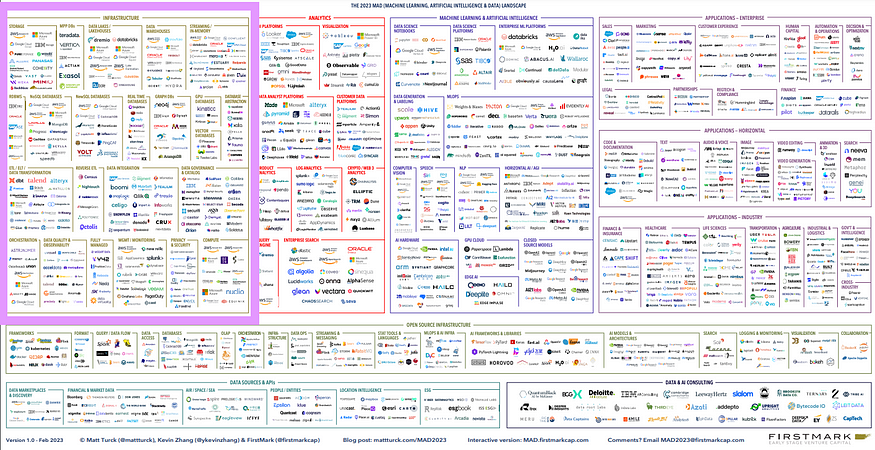

Мэтт Терк недавно опубликовал обзор ландшафта MAD (Machine Learning, Artificial Intelligence & Data) на 2023 год. Аналогичные графики создавались для 2012, 2014, 2016, 2017, 2018, 2019 (Часть I и Часть II), 2020 и 2021 годов, а теперь есть PDF-документ и интерактивная версия состояния этого ландшафта на 2023 год.

В этой статье кратко обобщается только “небольшая” часть экосистемы MAD, связанная с инфраструктурой данных:

Основные изменения в инфраструктуре данных на 2023 год

Hadoop

Несмотря на то, что некоторые компоненты экосистемы Hadoop до сих пор используются (например, Hive), их популярность снизилась настолько, что эта экосистема больше не попадает в ландшафт индустрии данных, что также подтверждается последними статьями из разряда “Big Data is Dead”.

Data lakes стали относиться к одной категории с Lakehouse

Сюда, среди прочих, относятся следующие инструменты (где это актуально, в скобках также указаны год основания и общий объем финансирования):

- Cloudera (2008, $1041 млн) — корпоративный дата-хаб, построенный на базе Apache Hadoop.

- Databricks (2013, $3497 млн) — их платформа lakehouse используется для сервисов интеграции и аналитики. Эта компания ввела парадигму lakehouse и выступает лидером в этой категории.

- Dremio (2015, $405 млн) — платформа аналитики данных, позволяющая компаниям запрашивать данные с любого источника и ускоряющая аналитическую обработку с помощью инструментов бизнес-аналитики, машинного обучения и клиентов SQL.

- Onehouse (2021, $33 млн) — облачный управляемый сервис формата lakehouse, помогающий создавать озера данных, обрабатывать данные и владеть данными в опенсорсных форматах.

- Azure Data Lake Storage — подобный S3 сервис объектного хранилища, обычно называемый ADLS Gen 2

- Azure HD Insight — аналогичен вышеназванному сервису, но для экосистемы Hadoop.

- GCP Google BigLake — позволяет создавать таблицы BigLake в Google Cloud Storage (GCS), Amazon S3 и ADLS Gen 2 в поддерживаемых открытых форматах файлов, таких как Parquet, ORC и Avro.

- GCP Google Cloud Dataproc — аналогичен сервису выше, но для экосистемы Hadoop.

- AWS Lake Formation — упрощает управление озером данных на базе S3 с интеграцией каталога метаданных Glue, механизма запросов Athena и так далее.

- AWS Amazon EMR — аналогичен сервису выше, но для экосистемы Hadoop (видите паттерн между поставщиками облачных услуг?).

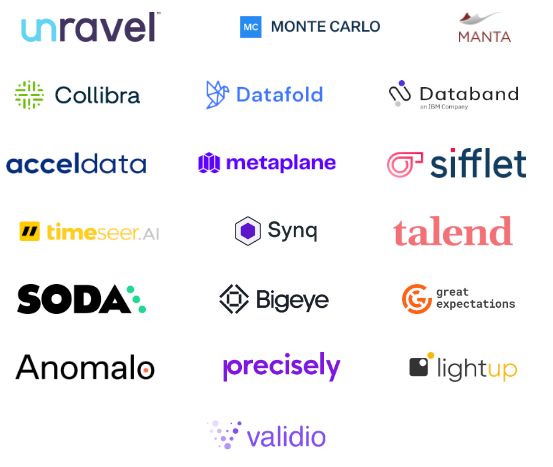

Новая категория: качество данных и наблюдаемость

Категория “качество данных” (Data Quality) была объединена с “наблюдаемостью данных” (Data Observability) ввиду все большего совпадения их функциональности. К инструментам в этой области относятся Precisely, Talend, Collibra, Manta, Unravel Data, Great Expectations, SodaData, Anomalo, Acceldata, Monte Carlo, Bigeye, Validio, Databand, Lightup, Metaplane, Datafold, Timeseer, Sifflet, Synq.

Как это влияет на покупателей и конечных пользователей? Эта большая категория сформирована еще не до конца, поскольку похожие платформы метаданных включены в отдельные категории (Управление и каталогизация данных, доступ к данным), хотя решают ту же задачу, что и вышеперечисленные инструменты: сбор метаданных и их использование для наблюдаемости, повышения качества, исследования, коллаборативного обмена знаниями и решения проблем.

Для средней дата-команды в SMB (малые и средние компании) эти три категории предоставляют фантастические инструменты, которые служат в качестве отличного дополнения стека, но зачастую не являются незаменимыми. И напротив, те же инструменты являются критически необходимыми для крупных корпораций, которые используют их для управления, строгого контроля и соответствия корпоративным стандартам.

Это означает, что многие из предоставляющих подобные услуги организаций стремятся стать базовыми инструментами, востребованными крупными корпоративными клиентами. Но за такими клиентами гонятся слишком многие из них. Успешными в этом секторе выглядят такие компании, как Monte Carlo, Acceldata и Collibra. Остальные либо имеют устоявшуюся базу клиентов, продажи которым они стремятся увеличить, либо ищут способы убедить SMB в том, что эта проблема достаточно важна, чтобы за ее решение можно было заплатить. Metaplane здесь выступает интересным аутсайдером, поскольку они также охватывают небольшие команды и даже предоставляют бесплатный вечный план для команд, состоящих из одного специалиста.

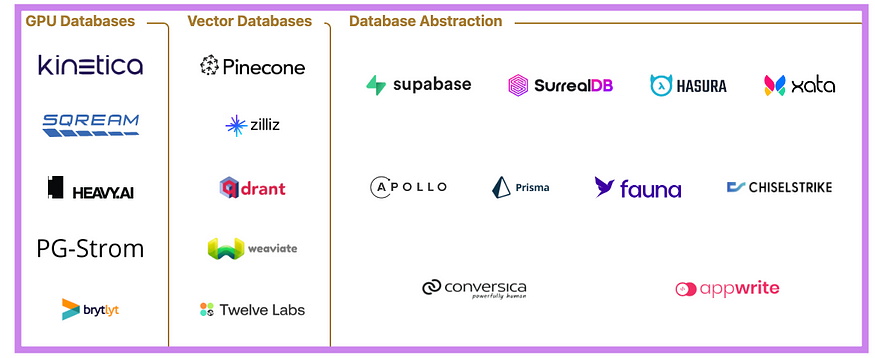

Новые категории баз данных

Также присутствуют категории баз данных для GPU-, векторных и бессерверных рабочих нагрузок.

Примечание: несмотря на то, что на ландшафте MAD это не отражено, наблюдается возрождение встраиваемых баз данных: DuckDB для OLAP, KuzuDB для Graph, SQLite для RDBMS, Chroma для поиска и RocksDB для пар ключ-значение.

Полностью управляемые платформы данных

Платформы “все в одном” появились в виде категории инструментов, которые в качестве альтернативы современному стеку данных обещают более целостные готовые решения. К ним относятся Mozart Data, Y42, FruitionData, Keboola, Nexla, 5x, Adverity и Data Virtuality.

Рост важности консалтинговых сервисов

Ввиду расширения и усложнения экосистемы услуги по “Консультированию в сфере данных и ИИ” стали настолько важными, что также были выделены в отдельную категорию.

Тренды в инфраструктуре данных на 2023 год

Объединение и унификация с позиции покупателей

Покупатели испытывают все большее финансовое давление и растущий надзор со стороны финансовых руководителей. В целях повышения контроля над затратами руководство подталкивает специалистов к выбору не лучших продуктов, а плотно интегрированных комплексных решений (чтобы вести переговоры с одним вендором и заключать один контракт). От дата-профессионалов требуют добиваться большего меньшими средствами. Руководство не нанимает новых сотрудников и не выделяет ресурсов для экспериментирования с непроверенными инструментами.

Объединение и унификация с позиции продавцов

Существует слишком много компаний, предлагающих схожие наборы решений, а также, что еще хуже, стартапов, предлагающих всего одно решение. Последние ориентируются на очень узкие категории — слишком узкие для устойчивого самостоятельного существования в долгосрочной перспективе. Сюда относятся обратные ETL, хранилища метрик, каталоги данных и так далее.

Каждая из таких компаний надеется стать более крупной платформой, но оказывается для этого недостаточно прибыльной. Поскольку их показатель cash runway (показатель того, на сколько времени хватит бюджета при текущем темпе расходов) обычно покрывает от нескольких месяцев до 3 лет, то в целях избежания банкротства такие компании сталкиваются с необходимостью в очередном раунде финансирования или поиске нового “дома” путем слияния с более крупной фирмой.

На противоположной стороне спектра Snowflake и Databricks соревнуются за становление базовыми платформами “данных и машинного обучения”. Они продолжают агрессивно наращивать набор предлагаемых услуг, стремясь охватить более обширный диапазон инфраструктуры данных. Обе эти компании уже поглотили ряд более мелких проектов (и наверняка продолжат это делать) с целью увеличения своего присутствия на рынке и набора предлагаемых услуг. Компания Confluent, основанная создателями Kafka, последовала аналогичному подходу, приобретя Immerok, компанию, разработавшую платформу Flink.

Объединение и унификация — прогнозы

Вот категории инструментов, нацеленных на унификацию:

- ETL и обратный ETL — аналогично тому, как Airbyte поглотила Grouparoo, Fivetran смогла поглотить одного из своих партнеров по обратному ETL (Census и Hightouch).

- Качество данных и наблюдаемость — сливаются в одну категорию при том, что наблюдаемость данных по-прежнему является столь новой, что заинтересованные покупатели зачастую не могут получить организационную поддержку при покупке такой услуги, особенно в период экономического спада. В критические моменты наличие этих инструментов оказывается очень кстати. Очень немногие пользователи, с которыми мне доводилось общаться, активно используют, оценивают или просят подобные продукты или возможности, несмотря на их очевидную значимость и полезность.

- Каталоги данных — на рынке присутствует очень много игроков, и пока не ясно, какие из них останутся и смогут продолжить самостоятельную жизнь, не будучи поглощенными более крупными платформами (управления/наблюдаемости или облачного хранилища данных).

Жертвование современным дата-стеком (MDS)

MDS (Modern Data Stack) представляет инструменты, зачастую считающиеся передовыми и даже элитными. Чтобы правильно задействовать такие средства, инженерам нужно потрать свое (дорогостоящее) время, сонастраивая их в соответствии с нуждами компании. Как правило, с инженерной точки зрения это обеспечивает высокую гибкость, модульность и адаптируемость. Однако в периоды, когда компании стремятся сократить расходы, многие покупатели оказываются вынуждены жертвовать некоторыми инженерными идеалами в угоду более интегрированных продуктов. В этой категории недавно начали набирать популярность полностью управляемые решения вроде Y42 и Keboola.

Линия между обратным ETL и CDP размывается

Customer Data Platform (клиентская платформа данных) является новой категорией продуктов, которые собирают данные из нескольких источников, выполняют их сегментацию и прочую аналитику, после чего передают эти данные обратно в SaaS для маркетинговых кампаний. Для этих целей зачастую использовался обратный ETL — после анализа данных в облачном хранилище с помощью, например HEX и dbt, вы могли отправить их обратно в SaaS. Представители обеих этих категорий начали понимать, что их действий недостаточно, и нужно расширять спектр возможностей:

- Инструменты для обратного ETL стали более CDP-подобными, предоставляя услуги прямой аналитики клиентских данных без необходимости задействовать для этого другие инструменты.

- CDP-продукты при этом начали обретать больше возможностей обратного ETL, повышая свою интеграцию с хранилищами данных.

Обе категории движутся в одном направлении.

Сетка данных, продукты и контракты

Во многих организациях стек данных выглядит как мини-версия ландшафта MAD (вместо некоторых логотипов присутствуют названия собственных систем). Сетка данных появилась в качестве одного из подходов, помогающих наладить работу в сложных средах.

В то время как матрица данных является чисто техническим принципом (один фреймворк, связывающий источники данных, независимо от их физического расположения), сетка данных управляет как инструментами, так и командами. Ее ключевой принцип связан с дата-продуктами, которые могут являться курируемыми дата-активами, моделями или API. Каждая независимая предметно-ориентированная команда дата-саентистов владеет такими продуктами и отвечает за управление ими, включая SLA (соглашение об уровне услуг) и обеспечение качества, а также предоставление их потребителям в формате самообслуживания. Некоторые считают, что контракты данных также помогают установить более четкие границы между создателями и потребителями данных, обеспечивая высокое качество этих данных.

Как не растеряться в столь большой экосистеме

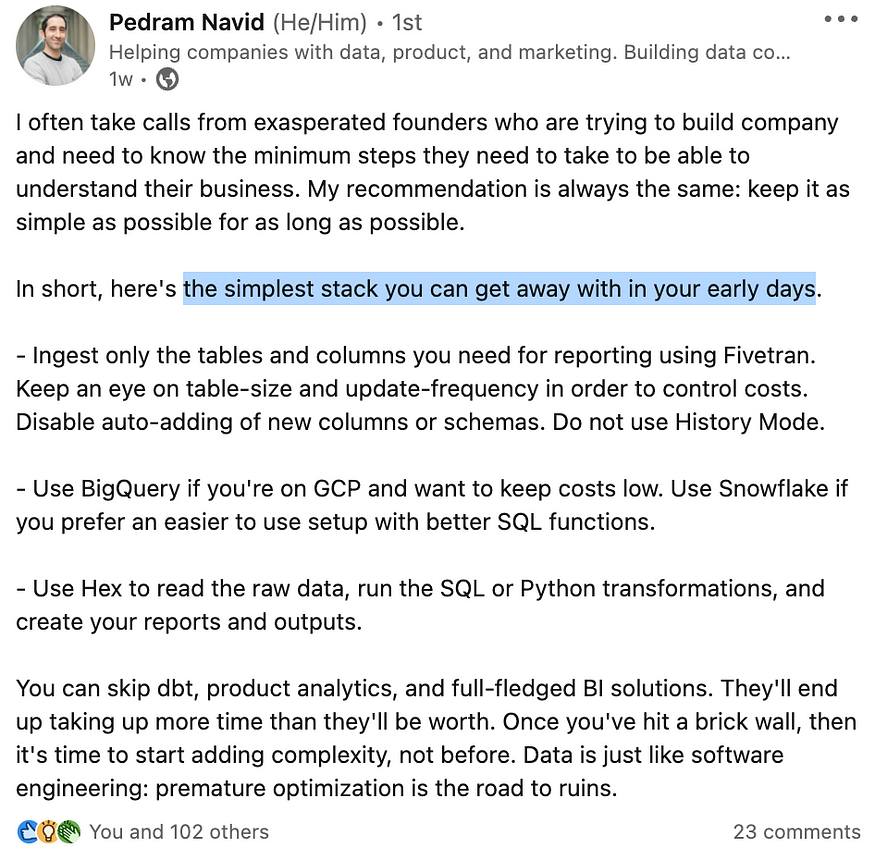

Старайтесь не внедрять инструменты, пока в них не возникнет очевидной потребности. Педрам Навид поделился по этому поводу хорошим советом на LinkedIn: начните с простейшего стека, включающего BigQuery, Fivetran и HEX. Таким образом вы получите бессерверное облачное хранилище данных (BigQuery), инструмент внедрения данных с распределенной системой оплаты (Fivetran), а также гибкое средство для аналитики и создания отчётов (HEX).

Перевод:

Мне зачастую звонят взволнованные учредители, которые пытаются построить компанию и хотят понимать, какие минимальные шаги необходимо предпринять, чтобы лучше понять свой бизнес. На это я всегда даю одну и ту же рекомендацию: старайтесь как можно дольше сохранять все максимально простым.

Если коротко, то вот простейший стек, которого вам будет достаточно на ранних этапах:

- Используйте Fivetran и принимайте только те таблицы и столбцы, которые вам необходимы для отчетов. Следите за размером таблиц и частотой их обновления, чтобы держать затраты под контролем. Отключите автоматическое добавление новых столбцов или схем. Не включайте History Mode.

- Используйте BigQuery, если работаете на GCP (Google Cloud Platform) и хотите сократить расходы. Используйте Snowflake, если предпочитаете более простые настройки с более удобными функциями SQL.

- Используйте Hex для считывания сырых данных, выполнения трансформаций через SQL или Python, а также создания отчетов и результатов.

Вы можете опустить dbt, аналитику продуктов и полноценные BI-решения. Все это затребует больше времени, чем принесет пользы. И только когда вы уже упретесь в стену, можно будет подумать об усложнении системы, но не раньше. Работа с данными аналогична разработке ПО: преждевременная оптимизация представляет прямой путь к разрушению.

Читайте также:

- Как писать идеальные конспекты по науке о данных

- Персонализация контента с IBM Watson

- Как вино может быть слегка острым и резким?

Читайте нас в Telegram, VK и Дзен

Перевод статьи Anna Geller: 2023 State of Data Infrastructure — Key Trends from Matt Turck’s MAD Landscape