В разгар популярности ChatGPT генеральный директор DeepMind Демис Хассабис дал интервью журналу Time, в котором упомянул о намерениях компании запустить в этом году аналогичную модель. В основе предполагаемого конкурента ChatGPT лежит Sparrow — модель, представленная в исследовательской работе DeepMind, опубликованной в конце 2022 года.

Первоначальная цель исследования Sparrow заключалась в создании более безопасных разговорных агентов. Теперь Sparrow, похоже, позиционируется как альтернатива ChatGPT от DeepMind.

Большие языковые модели (LLM) добились успеха в таких задачах, как ответы на вопросы, обобщение и диалог. Однако диалоговые агенты, работающие на основе LLM, иногда могут выдавать неточную и вымышленную информацию, использовать дискриминационные формулировки и поощрять небезопасное поведение.

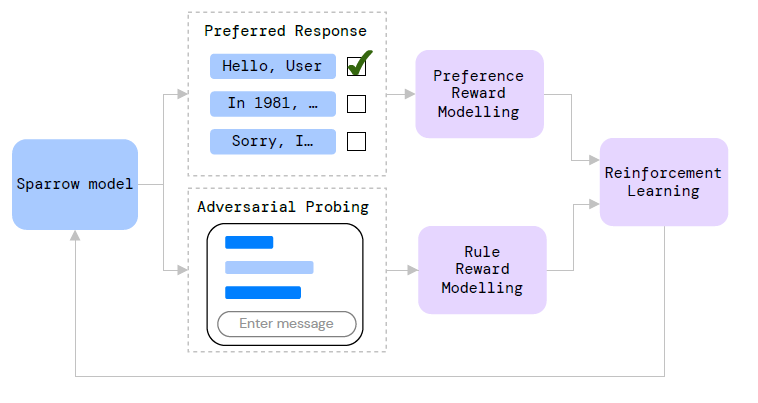

Чтобы решить эту проблему, DeepMind разрабатывает новые методы обучения диалоговых агентов с использованием обучения с подкреплением на основе обратной связи с человеком. Последней разработкой в этой области является Sparrow — диалоговый агент, снижающий риски небезопасных и неуместных ответов. Sparrow предназначен для общения с пользователем, ответов на вопросы и поиска информации в интернете с помощью Google для обоснования своих ответов.

Sparrow использует обучение с подкреплением на основе отзывов людей для обучения модели тому, насколько полезен тот или иной ответ. Участникам показывают несколько типовых ответов на один и тот же вопрос и спрашивают, какой ответ им больше нравится. Эти данные используются для того, чтобы Sparrow мог вести более удачные диалоги.

Чтобы поведение модели было безопасным, команда DeepMind определила набор правил для Sparrow, таких как “не делать угрожающих заявлений” и “не делать ненавистнических и оскорбительных комментариев”. Команда также обучает отдельную “правильную модель”, которая бы указывала на нарушение Sparrow каких-либо правил. Для этого участникам предлагают попытаться обмануть Sparrow и заставить модель нарушить правила во время взаимодействия с ней.

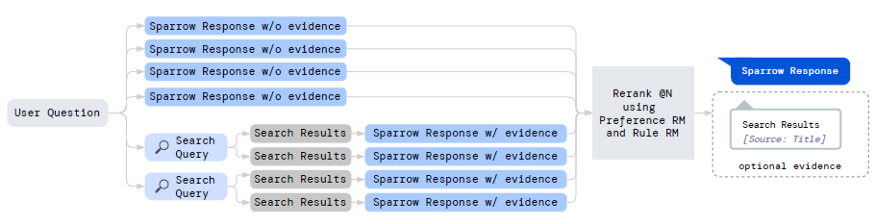

Одна из ключевых возможностей Sparrow — способность собирать доказательства при выработке ответа. На заданный вопрос Sparrow выбирает четыре ответа без доказательств и запускает два поисковых запроса в Google, которые выдают два потенциальных результата поиска.

Эти результаты условно дискретизируются для каждого результата поиска и оцениваются с помощью моделей “Вознаграждение за следование предпочтению” и “Вознаграждение за следование правилу”. Затем пользователю показывается результат, получивший наивысшую оценку.

Диалоговый агент Sparrow показал многообещающие результаты с точки зрения корректности и соблюдения правил. Участники сочли ответы Sparrow правдоподобными и подкрепленными доказательствами в 78% случаев. Однако есть еще возможности для улучшения, поскольку участники смогли обмануть Sparrow и заставить его нарушить правила в 8% случаев.

Хотя Sparrow является значительным шагом вперед в обучении безопасных и полезных диалоговых агентов, необходимы дополнительные исследования для разработки более полного набора правил и обеспечения схожих результатов в различных языках и культурных контекстах.

Цель дальнейшей работы заключается в том, чтобы лучше оценивать поведение искусственного интеллекта и лучше согласовывать его с человеческими ценностями посредством бесед между людьми и машинами.

Читайте также:

- Разработка приложения на ChatGPT: пошаговое руководство

- Взгляд в будущее: перспективы развития и влияния ИИ на изобразительное искусство и повседневную жизнь

- Все, что нужно знать о цифровых людях

Читайте нас в Telegram, VK и Дзен

Перевод статьи Jesus Rodriguez: Inside Sparrow: The Foundation of DeepMind’s ChatGPT Alternative